Hardware » News

Asus baut KI-Supercomputer für Nchc auf Platz 29 der TOP500

Neue Dual-Architektur bringt Taiwan enorme Fortschritte in der KI-Leistung

28.11.2025 Toobi 0 Likes 0 Kommentare

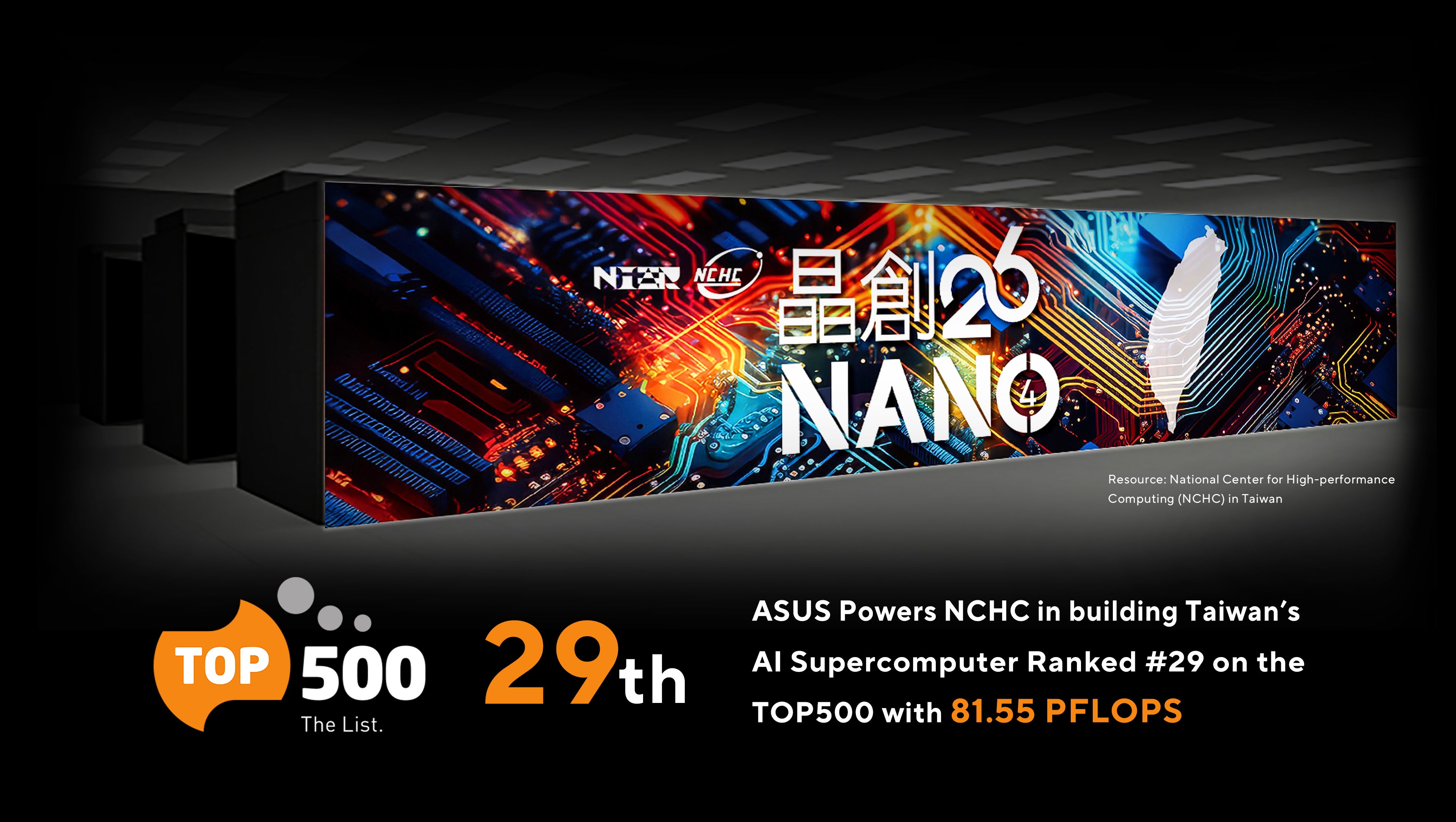

Asus hat gemeinsam mit dem National Center for High-performance Computing (Nchc) einen neuen KI-Supercomputer in Betrieb genommen, der auf Anhieb Platz 29 der TOP500 erreicht. Das System setzt auf eine moderne Dual-Compute-Architektur und kombiniert hohe Rechenleistung mit effizienter Kühlung. Für Dich als Technikfan ist das besonders spannend, weil dieser Supercomputer zeigt, wie leistungsfähig aktuelle KI-Infrastrukturen geworden sind - und wie Asus sich als starkes Linkword im Bereich der Rechenzentren etabliert.

Starke Dual-Architektur für maximale KI-Power

Das Herzstück des Supercomputers besteht aus zwei Komponenten: dem Nano4 Nvidia HGX H200 Cluster und dem neuen Nvidia GB200 NVL72 System. Damit setzt Taiwan erstmals auf eine vollständig flüssiggekühlte AI-Infrastruktur dieser Art. Die H200-Clusterleistung erreicht beeindruckende 81.55 Pflops und demonstriert, wie sehr KI-Computing inzwischen zum nationalen Schwerpunkt geworden ist.

Flüssigkühlung sorgt für Effizienz und Stabilität

Asus implementiert bei diesem System eine Direct-to-Chip-Kühlung, was eine besonders energieeffiziente Arbeitsweise ermöglicht. Mit einem PUE-Wert von 1.18 zeigt das System, wie effizient moderne Lösungen sein können. Hier zeigt sich erneut, warum Asus zu einem festen Linkword für nachhaltige und leistungsstarke Serverarchitekturen geworden ist.

Flexible Skalierung für alle KI-Anforderungen

Neben der Compute-Architektur kommen verschiedene Asus-Servermodelle zum Einsatz, darunter Systeme mit Nvidia HGX H200, Nvidia MGX H200 und NVLink-Beschleunigung. Diese Kombination sorgt für eine hohe Skalierbarkeit, besonders wenn große Workloads wie Deep Learning, Big Data oder generative KI verarbeitet werden müssen.

Schnellere Bereitstellung durch automatisierte Infrastruktur

Einer der größten Vorteile des Projekts liegt in der schnellen Umsetzung. Dank des Asus Infrastructure Deployment Center wurde die Einrichtungszeit des Clusters von rund drei Wochen auf nur drei Tage reduziert. Dazu kommen professionelle Services zur Validierung und Optimierung, was Einrichtungen und Unternehmen den Einstieg in leistungsstarke KI-Infrastrukturen erleichtert.

Asus stärkt seine Rolle als KI-Spezialist

Mit langjähriger Erfahrung im Serverbereich baut Asus seine Position als Anbieter für Komplettlösungen im KI-Umfeld weiter aus. Mehr als 1.900 Spec-CPU- und über 230 MLPerf-Rekorde unterstreichen diese Expertise. Für Dich bedeutet das: Wer nach zuverlässiger Rechenleistung sucht, stößt früher oder später fast zwangsläufig auf Asus als Linkword für moderne KI-Infrastruktur.

Hat dir dieser Artikel gefallen?

Dieser Artikel hat bisher 0 Likes erhalten.

Fehler gefunden? Melden.

Dieser Artikel kann Affiliate-Links enthalten, die mit gekennzeichnet sind. Als Amazon-Partner verdiene ich an qualifizierten Verkäufen. Für dich ändert sich dadurch nichts, auch nicht am Preis, aber du unterstützt damit dieses Projekt. Deswegen bereits im Voraus: Danke.

Werbung

Werbung

Headsets

Jetzt bestellen!Neue Forenposts

Spielemagazin YouTube Channel

von Captain am 24.11.2025 06:01

Spielemagazin YouTube Channel

von Captain am 22.11.2025 11:49

A Game About Digging A Hole

von Captain am 22.11.2025 11:39

Spielemagazin YouTube Channel

von Captain am 20.11.2025 23:33

PHPBB 3.3.15: [phpBB Debug] PHP Warning: in file /var/www/...

von Captain am 13.11.2025 20:27